L’intelligence artificielle révolutionnera-t-elle la médecine? La Belgique, qui ambitionne de devenir une Smart Nation, multiplie les projets et les partenariats. L’un d’eux permet d’aider le médecin à établir des diagnostics. Les possibilités d’applications pour le futur sont immenses.

Février 2020, un flux ordinaire de patients occupe les urgences du pays. Mi-mars, c’est l’hécatombe. Les clusters se multiplient dans les maisons de repos, la population est confinée et les unités de soins commencent à saturer. Le plan d’urgence est déclenché dans l’ensemble des hôpitaux belges. Les consultations et les opérations non urgentes sont suspendues pour permettre aux soignants de se consacrer presque exclusivement aux patients atteints du coronavirus.

Un état d’urgence dans lequel ils ont travaillé jour après jour, vague après vague. Au quotidien, les médecins ont enchaîné les diagnostics alors que tous les symptômes de cette nouvelle souche du Sars-CoV-2 n’étaient pas encore connus. On n’avait encore aucune idée de ce qu’était le Covid long ni de quand arriveraient les premiers vaccins, les premiers traitements spécifiques. Dans les unités Covid, on testait tout ce qui pouvait soulager les patients et freiner la progression de la maladie. On avançait à tâtons face à un virus qui fauchait à grande vitesse.

C’est dans ce contexte de nécessité absolue qu’ont été éprouvés de nouveaux programmes d’aide à la pratique médicale. Non pour remplacer l’expertise des médecins mais pour les épauler dans l’identification de la pathologie et les guider dans le choix du traitement à administrer.

C’est dans le contexte de nécessité absolue lié au Covid qu’ont été éprouvés de nouveaux programmes d’aide à la pratique médicale. Non pour remplacer l’expertise des médecins mais pour les épauler.

C’est le cas du projet européen Dragon, financé à hauteur d’un peu plus de onze millions d’euros par l’IMI (Innovative Medicines Initiative, initiative conjointe de la Commission européenne et de la Fédération européenne des associations et industries pharmaceutiques) et réunissant une vingtaine d’acteurs internationaux issus du monde médical, académique et industriel.

Le consortium ainsi formé a l’ambition de développer des algorithmes permettant de créer des systèmes d’aide à la décision médicale pour le diagnostic, au choix des traitements et à la sélection des cas Covid pour les essais cliniques. C’est une société liégeoise spécialisée dans l’analyse d’images dans le domaine du cancer, OncoRadiomics, qui a mis au point la technologie utilisée pour Dragon.

Une autre start-up belge, MedC2 (Medical Cloud Company), est également associée au projet. Experte dans le développement d’applications destinées à accompagner les médecins et les malades dans la gestion du Covid, sa mission est de proposer à ces derniers de l’information individualisée par le biais de modèles prédictifs.

Mimer le raisonnement

«Le projet Dragon consiste à retrouver des éléments, dans le dossier du patient, qui peuvent prédire la survenue d’un diagnostic précis. L’algorithme seul ne peut permettre au médecin de prendre une décision, mais la machine l’aidera à trouver une solution plus rapidement. Il doit, sur la base de données qu’on lui fournit, aboutir à la meilleure décision possible et apprendre à travers l’utilisation de ces données. Ce que la machine ne peut pas faire, par contre, c’est extrapoler et interpréter les conclusions auxquelles elle arrive. En aval, il y a donc un travail humain qui reste très important», expose Giovanni Briganti, directeur d’AI4Health, le groupe de travail d’AI4Belgium, expert en intelligence artificielle dans le domaine de la santé et enseignant à l’ULB et à l’UMons.

Ces conclusions, le programme d’intelligence artificielle les obtient, poursuit Giovanni Briganti, «en analysant une série de variables, de données de départ (input) encodées, comme le taux d’oxygène, l’anosmie ou la fièvre, pour permettre au soignant de prédire si la personne risque de développer la maladie ou pas (output). Un médecin pourrait aboutir à la même conclusion, mais cela lui prendrait beaucoup plus de temps. L’intelligence artificielle, elle, mimera ce raisonnement en l’adaptant à chaque cas spécifique. Cette technologie va également plus loin que l’analyse de données statistiques qui ne tient pas compte de la complexité des informations et des interactions entre les différents paramètres.»

Les yeux fermés?

Faire confiance à un logiciel quand on a entre les mains la vie de dizaines de cas Covid dont l’état peut dégénérer très rapidement: le pari n’est-il pas trop risqué? Comment s’assurer que le diagnostic que livre la machine est correct, que le traitement qu’elle préconise est bien celui qui soignera au mieux le patient? «Les médecins qui utilisent le programme ne partent pas de rien. Ils savent quelles sont les associations possibles entre un symptôme, une variable et un diagnostic. La question porte sur le choix des variables qu’on introduira dans le programme quand on a déjà une petite idée de la conclusion à laquelle le modèle aboutira. C’est ce qu’on appelle «l’approche supervisée».

En cas d’incertitude, on opte pour une approche non supervisée, afin de laisser au modèle le temps de rechercher d’autres diagnostics et de mettre en évidence des associations imprévues. Dans les deux cas, c’est donc bien le modèle qui, à la base, est informé par l’humain.»

Les performances établies par le modèle sont analysées par la suite pour évaluer si, pour chaque cas, il a correctement prédit la maladie ou son évolution. La cohérence des résultats et la fiabilité sont également évaluées à travers le procédé de réplication qui consiste à soumettre à la machine un échantillon qui lui est inconnu pour vérifier si elle décèle la même pathologie. «Il faut aussi éviter d’introduire trop de variables dans le système: en effet, s’il devient trop performant sur les données de départ, il risque de l’être moins lorsqu’il sera appliqué dans un nouveau contexte. Un juste milieu s’impose.» Ce n’est qu’en évaluant le poids de chaque variable et sa contribution à la prédiction dans la population en général qu’on évitera d’arriver à un modèle trop affiné, donc moins facilement transposable.

Se pose aussi la question des sensations, comme la gêne ou la douleur. Voire l’absence trompeuse de gêne ou de douleur, comme on a pu le constater dans les cas d’hypoxie heureuse où les malades présentent une forte désaturation en oxygène sans s’en sentir mal, et que seul le médecin peut appréhender. Une écoute précieuse et une expertise basée sur des années de pratique que la machine ne pourra jamais remplacer. Dès lors, ne risque-t-elle pas de passer à côté d’ informations capitales?

«Avec le Covid, la plupart des symptômes rapportés pouvaient être objectivés au moyen de tests», rassure Giovanni Briganti. C’est le cas notamment pour la perte d’odorat, un peu moins pour le goût. Et si c’était la grippe et non le Covid? Au début de l’épidémie, les médecins eux-mêmes n’ont pas toujours été capables de faire systématiquement le distingo. «Pour différencier la grippe du Covid, on examine quels symptômes sont coprésents chez l’individu. On peut aussi utiliser le modèle en lui soumettant le même type de variables ou des variables différentes, en mode supervisé ou non. Il affichera alors tous les résultats possibles, toutes les pathologies envisageables.» On en revient à cette notion d’extrapolation et d’interprétation, qui reste de la responsabilité du médecin.

Le recours à l’intelligence artificielle ne doit pas faire peur. Cela reste un outil, on en fait ce qu’on veut.

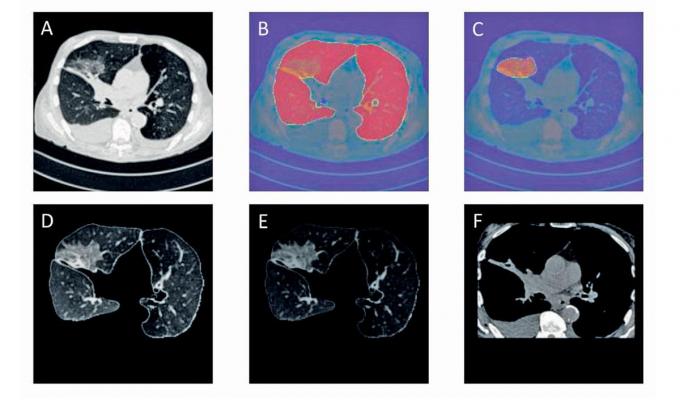

Au CHU de Liège, qui est associé au projet européen, on travaille avec Dragon depuis plusieurs mois. Le modèle, met en avant le Dr Julien Guiot, chef de clinique au service pneumologie, a permis de compléter les informations obtenues avec le scanner des poumons – à savoir, le patient est-il probablement atteint du Covid ou non? – en livrant dans une certaine mesure des précisions sur la sévérité de la maladie, chose que l’observation seule ne permet pas systématiquement d’objectiver. «Avant la pandémie, l’usage de ce type de modèle était peu envisageable dans notre pratique quotidienne, reconnaît-il. Aujourd’hui, il apparaît que ces outils peuvent apporter des informations complémentaires utiles aux cliniciens.»

Le diagnostic de votre prochaine crise grâce à l’intelligence artificielle?

L’autre enjeu du programme Dragon est de parvenir à pouvoir transposer ce type d’approche à l’étude d’autres pathologies que le Covid-19, comme les maladies cardiovasculaires ou neurologiques, voire à l’ensemble des pathologies. Et de dépasser le champ du diagnostic pour l’ouvrir à d’autres possibilités. On peut imaginer, par exemple, pouvoir prédire un jour quand un épileptique fera sa prochaine crise ou le risque d’hypoglycémie chez un diabétique. Ou encore améliorer la prévention en conseillant mieux la personne sur le style de vie à adopter pour prendre soin de sa santé, etc.

Les chercheurs entrevoient aussi des avancées dans la recherche contre le cancer. Exemple: l’analyse par le logiciel des résultats de scanner mettant en évidence un nodule ou une masse pourrait permettre de déterminer de quel cancer il s’agit. Autant d’applications qui devraient pouvoir également augmenter la performance des outils existants et, pourquoi pas, réduire la facture des examens médicaux nécessaires pour établir les diagnostics puisque ceux-ci seraient obtenus plus rapidement.

Se pose aussi la question du choix éclairé du patient. Sera-t-il informé que le traitement qu’on lui a prescrit a été suggéré par l’intelligence artificielle? «Il faut lui expliquer l’intérêt du choix de l’outil, et que les programmes développés doivent répondre à des standards de qualité pour pouvoir être utilisés. Le recours à l’intelligence artificielle ne doit pas faire peur. Cela reste un outil, on en fait ce qu’on veut. Elle ne remplacera jamais le médecin. La question qui se pose est plutôt: peut-on proposer de l’intelligence artificielle au patient?, pointe encore le Pr Guiot. Bien sûr, ces belles avancées ne seront possibles que moyennant un financement afin d’avancer de manière concertée et pluridisciplinaire dans le développement de ces outils. Les développeurs doivent idéalement rencontrer une demande des praticiens et des malades afin d’améliorer la prise en charge globale. L’ajout de nouveaux outils mènera indéniablement à un coût qui devra être intégré dans la stratégie des soins du futur, afin de maintenir un niveau de soins d’excellence tout en se préservant du risque d’une médecine coûteuse, voire inaccessible.»

Il sera dès lors essentiel de convaincre les praticiens, qui ont toujours dû tabler sur leurs propres connaissances et sur l’expertise acquise, de l’utilité et de la fiabilité de cette aide à la décision clinique. Et qu’ils seront toujours aux commandes face à la machine.

Intelligence artificielle et médecine 4P

Le projet Dragon n’ est qu’un exemple parmi d’autres d’applications de l’intelligence artificielle dans le secteur médical. «De nombreuses recherches sont menées dans toute une série de secteurs, notamment les maladies neurologiques ou les cancers. Pour celui du sein, par exemple, c’est dans le domaine du dépistage et de l’aide au traitement par radiothérapie qu’on constate les plus grandes avancées», précise Benoit Macq, professeur à l’école polytechnique de l’UCLouvain et cocoordinateur du projet Trail (Trusted IA Labs), un institut dont font partie cinq universités francophones (UCLouvain, ULiège, UMons, ULB et UNamur) et quatre centres de recherche en nouvelles technologies (Sirris, Multitel, Cetic et Cenaero).

L’intelligence artificielle s’intègre aussi dans ce qu’on appelle la «médecine 4P» pour personnalisée, préventive, prédictive (évaluer les risques de développer une maladie) et participative (le patient est acteur de sa santé). Une approche ciblée qui vise à identifier les populations présentant les mêmes prédispositions à certaines pathologies ou susceptibles de répondre de manière similaire à un traitement. «La médecine prédictive va de plus en plus loin dans l’analyse de l’ADN. Quant à la médecine participative, elle a pour principe d’associer le patient à la prise de décision en fonction de ses valeurs, des questions d’inconfort, et de privilégier la qualité de vie en s’appuyant sur les prédictions que le modèle peut livrer», complète Benoit Macq.

Si la médecine prédictive peut aider le praticien à déceler la maladie avant qu’elle ne se déclare, elle a un désavantage de taille, poursuit-il: «Le programme a été conçu sur le modèle des hôpitaux universitaires et ne s’adapte pas toujours très bien aux hôpitaux périphériques. Raison pour laquelle il faut opter pour une intelligence artificielle codéveloppée par l’ensemble des hôpitaux, qui puisse s’adapter aux différents types de données et aux diverses pratiques médicales.»

La concrétisation de ces projets implique la collecte et l’utilisation de données sensibles. Or, les risques de piratage et d’exploitation sont réels, comme le confirme Jean Vanderdonckt, professeur en technologies à l’UCLouvain. «L’utilisation de programmes d’apprentissage de la machine nécessite une quantité énorme de données qui vont être stockées dans un seul endroit. En interne, il n’est pas exclu que quelqu’un de mal intentionné puisse en faire un mauvais usage, même si des procédures d’accès à haut niveau d’habilitation limitent les risques. En externe, c’est surtout pendant la période d’entraînement du programme (NDLR: lorsque les données y sont intégrées pour qu’il puisse devenir autonome par la suite) que le risque de piratage est le plus élevé».

Et ce, bien que toutes les informations soient anonymisées ou pseudonymisées, c’est-à-dire en remplaçant directement les indications sur l’identité du patient par des données relatives à sa pathologie, et en empêchant une réidentification directe des individus. Une méthode qui permet à la machine d’apprendre plus vite mais qui comporte aussi davantage de risques pour la sécurité des données, met en balance le spécialiste de l’interaction homme-machine.

Dans un récent rapport, la Commission européenne préconise que les programmes fassent leur entraînement séparément dans chaque hôpital et que seuls les résultats du traitement des données soient injectés dans le programme central. En cas de piratage, le vol serait dès lors limité à un service ou une unité. Outre le Règlement général sur la protection des données (RGPD) qui fournit déjà un corpus de garanties, complète Benoit Macq, chaque hôpital a un délégué à la protection des données et travaille main dans la main avec des experts en cybersécurité. Enfin, l’accès aux données par les sociétés privées doit faire l’objet d’une validation par les directions des centres hospitaliers.