Au commencement, l’Homme dit: «Que l’Intelligence artificielle soit!», mais l’IA ne fut point. Il fallut force pérégrinations pour la créer.

«L’IA a une longue histoire, confirme Bruno Bachimont, informaticien, philosophe du numérique et enseignant-chercheur à l’université de technologie de Compiègne. Dans la longue durée, elle s’inscrit dans la lignée de deux traditions qui ont convergé progressivement: celle qui a consisté à voir la pensée comme un calcul, et celle qui a cherché à construire des machines qui calculent. Evidemment, la rencontre des deux se traduit par la recherche de machines pensantes que l’on connaît aujourd’hui. Mais l’idée que la pensée n’est après tout qu’une combinatoire de symboles, que l’on peut rapporter à un calcul fait sur des signes ou des nombres, est en réalité assez ancienne.»

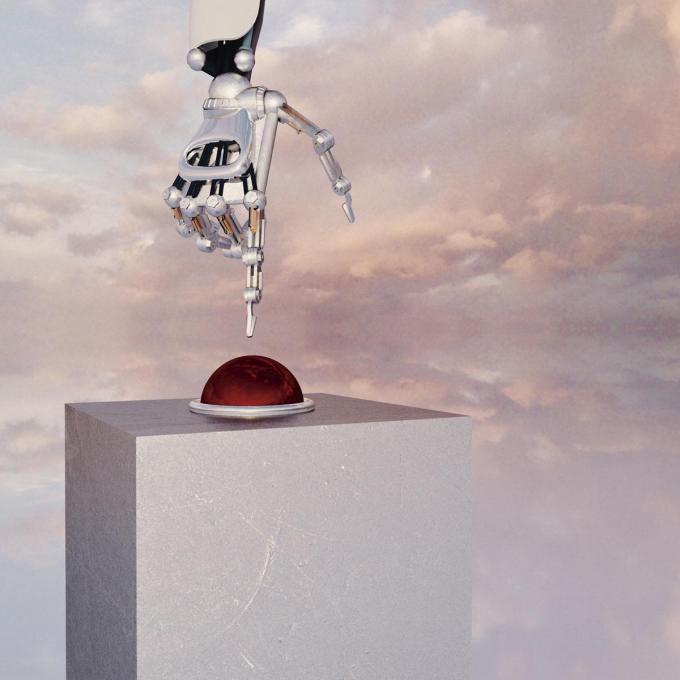

Premier commandement de l’IA: la nature des systèmes dits intelligents tu comprendras.

On trouve en effet les premières velléités de traduction de la pensée en calcul chez des philosophes classiques. Hobbes (1588-1679), l’auteur du Léviathan, l’immortalisa par la célèbre formule «Reason is nothing but reckoning» (La pensée n’est rien sinon un calcul). Quelques décennies plus tard, Leibniz (1646-1716) prit le relais en s’aventurant à formuler différents formalismes visant à traduire les raisonnements par un calcul. Au même moment, l’ardent catholique Blaise Pascal (1623 – 1662) initia, grâce à la «Pascaline», «une tradition de machine à calculer, qui se prolongera jusqu’à la machine analytique du polymathe Charles Babbage (1791 – 1871), même si ce dernier n’a pas pu la construire comme il l’entendait», précise Bruno Bachimont.

Il a fallu néanmoins patienter jusqu’au XXe siècle pour voir les deux traditions converger. Leurs noces furent célébrées en 1942 sous le signe de la «cybernétique». En pleine Seconde Guerre mondiale, le gotha des savants et scientifiques lançait un cycle de conférences – les «Conférences de Macy» – pour réfléchir aux mécanismes de la pensée et leur modélisation. Elles accoucheront de deux articles, «publiés tous deux en 1943: le premier, “Behavior, Purpose and Teleology” signé par Rosenbluth, Wiener et Bigelow, montrait comment un système fondé sur la rétroaction négative, à savoir le fait de prendre en compte l’action effectuée pour corriger la suivante – ce que fait une torpille qui corrige sa trajectoire pour se rapprocher de sa cible –, pouvait simuler le fait d’avoir des buts et des intentions», précise l’auteur de Le Sens de la technique: le numérique et le calcul (Encre Marine, 2010). Le second article, intitulé «A Logical calculus of the Ideas Immanent in Nervous Activity», est signé McCulloch et Pitts. En substance, celui-ci soutient que si on estime le cerveau comme un assemblage de neurones formels, on peut le considérer comme une machine à calculer ayant la puissance d’un ordinateur.

C’est à ce moment précis que naquit l’histoire de l’IA. «Le premier article allait produire ce qu’on a appelé par la suite “le contrôle des systèmes” ou “l’automatique”, le second l’approche neuronale du calcul», ajoute Bruno Bachimont. Wiener, coauteur du premier article, établissait une équivalence entre le contrôle des systèmes vivants et artificiels. «Il avait été frappé par l’analogie entre les oscillations des systèmes de défense antiaérienne déficients et celles propres à certains troubles neurologiques. Il devait y avoir une théorie générale des systèmes qui transcende les différences entre vivant et mécanique, naturel et artificiel», poursuit Bruno Bachimont.

L’impitoyable bataille d’Abel et Caïn

L’idée de mettre en œuvre des machines dotées de la puissance du cerveau et capables de raisonner continua de faire son chemin. «Durant l’été 1956, vingt chercheurs, dont John McCarthy et Marvin Lee Minsky, se réunirent sur le campus de l’université américaine privée de Dartmouth grâce notamment à des subventions de l’armée américaine, raconte Laurence Devillers, professeure en informatique appliquée aux sciences sociales à l’université Paris-Sorbonne. N’oublions pas qu’ “intelligence” peut avoir le sens de renseignement en anglais.» Cette université d’été donnera ses lettres de noblesse à l’IA. La discipline est désormais reconnue comme une science à part entière, apte à séduire et attirer des financements, privés et publics, et à passionner les chercheurs. Aussi, c’est dans le sillage de cette université d’été que le terme «intelligence artificielle» fut forgé. «Comme le souligna John Haugeland par la suite, l’enjeu n’était pas de simuler ou d’approximer l’intelligence humaine, mais de trouver les principes généraux de l’intelligence pour être», complète Bruno Bachimont.

L’idée étant posée, l’enjeu était de lui donner corps. Une série d’allers-retours entre différentes approches, deux en particulier, sera ainsi déclenchée. Tels Abel et Caïn, l’approche neuronale et l’approche mathématique se livrèrent une impitoyable bataille. Aventure au scénario hitchcockien, Bruno Bachimont la résume dans ses grands épisodes: «Au début, s’inspirant de l’ouverture de McCulloch et Pitts, Frederik Rosenblatt proposa de concevoir des réseaux de neurones formels. Mais en 1969, Minsky et Papert montrèrent que cette approche était limitée, car elle ne pouvait prendre en compte les raisonnements à partir d’une certaine complexité logique. On développa alors des approches différentes fondées sur la logique mathématique qui se traduisaient par des machines appelées “systèmes experts”, qui reproduisaient dans la machine le raisonnement expert humain sur des connaissances formalisées.» L’approche neuronale n’avait toutefois pas dit son dernier mot: dans les années 1980, un nouveau type de réseau et une méthode de calcul associée permirent de lever les limitations posées par Minsky et Papert. Il fallut néanmoins attendre les années 2000 pour créer des machines correspondantes: «Celles-ci ont besoin de beaucoup de données numériques, qu’il faut pouvoir réunir, ce qu’il était alors possible de faire grâce à la numérisation progressive des différentes activités ; elles doivent en outre être capables de faire des calculs en grand nombre, les machines devaient donc être suffisamment puissantes. Depuis, ces outils ne cessent de s’améliorer et de proposer des applications de plus en plus troublantes dans leur capacité à reproduire ou simuler nos tâches intellectuelles de manipulation de symboles (écrire, parler) ou de contenu (produire des sons, des images, etc.).»

Si la genèse de l’intelligence artificielle fut si agitée et connut tant de rebondissements, c’est que les enjeux furent de taille. L’histoire de l’IA est animée par un projet scientifique qui rivalise sans cesse avec une utopie technologique. Le premier commandement du catéchisme de l’IA, son projet scientifique, est «de comprendre la nature des systèmes dits intelligents, ou de manière générale des systèmes cognitifs, c’est-à-dire ceux que l’on doit décrire comme possédant des connaissances si on veut comprendre ce qu’ils font. En dégageant ces principes généraux, l’objectif est de les produire sur des systèmes techniques, en général informatiques, pour qu’ils manifestent les comportements intelligents, ou cognitifs attendus», détaille Bruno Bachimont. Mais c’est sans doute dans l’utopie technologique que se niche le suc des enjeux autour de l’IA. Ses pères nourrissaient en effet le rêve de pouvoir construire des solutions générales à toutes sortes de problèmes humains et sociaux: le handicap, moteur ou cérébral, la gestion du travail, etc. C’est le deuxième commandement du catéchisme de l’IA.

Deuxième commandement de l’IA: des solutions aux problèmes humains et sociaux tu construiras.

Fausses croyances

Contrairement à un imaginaire abondamment nourri par les films et la littérature SF, les premiers effets de l’IA sur le monde social furent marginaux. Les spécialistes consultés sont unanimes à ce sujet. On retiendra néanmoins le phénomène Eliza, premier chatbot de l’informatique moderne, sorte de prélude balbutiant à ChatGPT. «En 1965, Joseph Weizenbaum, professeur au Massachusetts Institute of Technology (MIT), met au point un système conversationnel qui imite le dialogue d’un patient avec un psychiatre, évoque Alexei Grinbaum, président du Comité opérationnel d’éthique du numérique du Commissariat à l’énergie atomique. La technique, relativement simple, consiste à retourner chaque réplique en une question.» Par l’intermédiaire d’une interface de dialogue écrit, on pouvait en effet s’adresser à Eliza qui répondait par des questions en fonction de mots clés reconnus dans les énoncés qu’on lui soumettait.

«Eliza provoqua un changement d’ordre anthropologique majeur, insiste Bruno Bachimont. Mécanisme sommaire, il a connu un succès insoupçonné: Weizenbaum laissait la machine en libre accès pour recueillir des données et nombre de personnes se sont prises au jeu au point de se confier à elle comme à un véritable psychanalyste, et de refuser de croire à la fin qu’il ne s’agissait que d’une machine. Autrement dit, notre compréhension spontanée des comportements qui nous entourent est souvent fondée sur une reconnaissance d’intention et de connaissance qui animeraient ces comportements. C’est en général très efficace, même quand on sait que c’est faux: on le fait avec certaines de nos machines quotidiennes. Mais quand ces machines se mettent à parler, à produire des textes, etc., cette attitude anthropomorphique, ou plutôt cognitivo-morphique (on suppose des intentions et des connaissances dans les entités avec lesquelles on interagit), nous piège et nous croyons véritablement avoir affaire à des entités intelligentes comme nous, voire plus puisqu’elles ont accès à des moyens démesurés.»

Pour Laurence Devillers, l’affaire est entendue: «La génération des textes en langue naturelle était déjà un des objectifs dès le commencement des recherches sur l’IA, mais elle explose en 2022 avec l’arrivée de ChatGPT, agent conversationnel qui interroge un énorme modèle de langage nourri par de gigantesques corpus de textes collectés sur Internet. Le langage des agents conversationnels est, contrairement à l’humain, dépourvu d’expérience vécue, de perception physique, de sentiment ou de raisonnement. Nous créons un univers linguistique sans expérience corporelle et sans compréhension du sens, sans espace et sans temporalité.»

Un goût de fruit défendu?

Parmi les griefs féroces adressés à l’IA aujourd’hui, revient en leitmotiv celui du remplacement de l’être humain, voire de sa déshumanisation. Autrement dit: l’homme est-il perdu pour avoir goûté au fruit de l’arbre de l’IA? Rien n’est moins sûr, estime Bruno Bachimont: «Dans les nombreux développements que connaît l’IA, il est difficile de dire que la créature a échappé à son maître. Les machines sont toujours aussi stupides qu’avant et l’intelligence reste toujours l’apanage du vivant. On peut faire le parallèle avec le monde industriel: nous répliquons péniblement dans nos laboratoires et usines, avec des moyens pharaoniques, des procédés que la nature effectue à des coûts (énergétiques notamment) bien moindres. De même, l’IA arrive à nous battre à certaines tâches avec des moyens qui dépassent l’entendement (des milliards de données) et des coûts énergétiques toujours plus importants. C’est parce que l’IA ne présente aucune intelligence, contrairement aux systèmes vivants, qu’il faut compenser ce manque par une débauche de moyens. Mais le problème n’est pas de savoir si la machine est intelligente ou non, mais si nous faisons tout avec intelligence.»

Ce genre de conclusion optimiste ne fait cependant pas l’unanimité. Du philosophe Eric Sadin au mathématicien Daniel Andler, on ne compte plus les pourfendeurs des effets nocifs potentiels de l’IA. De son côté, Laurence Devillers tient une position équilibrée et pointe le rôle décisif de l’éducation: «Toute langue humaine véhicule nécessairement une histoire et une culture, contextualise-t-elle. Doit-on avoir peur de ce que nous créons? De ces machines qui nous parlent dans notre langue? Je pense que le principal problème est le manque d’éducation sur ces sujets. Pourquoi l’école ne fait-elle pas son travail: rendre les citoyens égaux d’apprendre comment marche le monde? La science est au cœur de cette compréhension. Démystifions ces sujets de manipulation et parlons d’éthique du numérique», conclut-elle.

Puisse cette série d’été y contribuer. Amen.

Ce fut le premier jour …

La Genèse de l’IA (1/7)

Episode 1: 29 juin

Et l’Homme créa l’IA

Episode 2: 6 juillet

Comment l’IA modifie notre perception de la réalité

Episode 3: 13 juillet

Bouleversera-t-elle notre rapport à la finitude des choses?

Episode 4: 27 juillet

Les conséquences sur la connaissance du monde qui nous entoure

Episode 5: 3 août

L’IA nous permettra-t-elle de dialoguer avec les animaux?

Episode 6: 10 août

Les conséquences sentimentales de l’IA

Episode 7: 17 août

Rendra-t-elle l’humain paresseux?