Les modèles d’intelligence artificielle ne se contentent plus de produire du contenu à partir de créations humaines, ils puisent désormais dans ceux déjà générés par l’IA. Avec comme conséquence une homogénéisation des contenus, voire une dégradation. Certains craignent déjà l’effondrement de l’intelligence artificielle.

A cause de l’IA, Internet voit-il le monde en jaune? C’est en tout cas la question que se pose un certain nombre d’internautes depuis plusieurs mois; suite à la déferlante d’images générées par l’intelligence artificielle «dans le style Ghibli». Au point que certains spécialistes de la retouche partagent désormais, sur leur site ou dans des vidéos YouTube, leurs conseils pour déjaunir les images fruits de l’IA.

La raison de ce jaunissement: l’auto-alimentation de l’intelligence artificielle. Désormais, pour produire de nouvelles images, celle-ci puise non seulement dans des contenus créés par l’homme, mais aussi dans des contenus générés par elle-même. Une forme de consanguinité qui uniformiserait les contenus, qu’il s’agisse d’images ou de textes, et risquerait de les appauvrir, voire carrément de les fausser..

«C’est un peu comme une photocopieuse qui recopie sans cesse une copie de copie.»

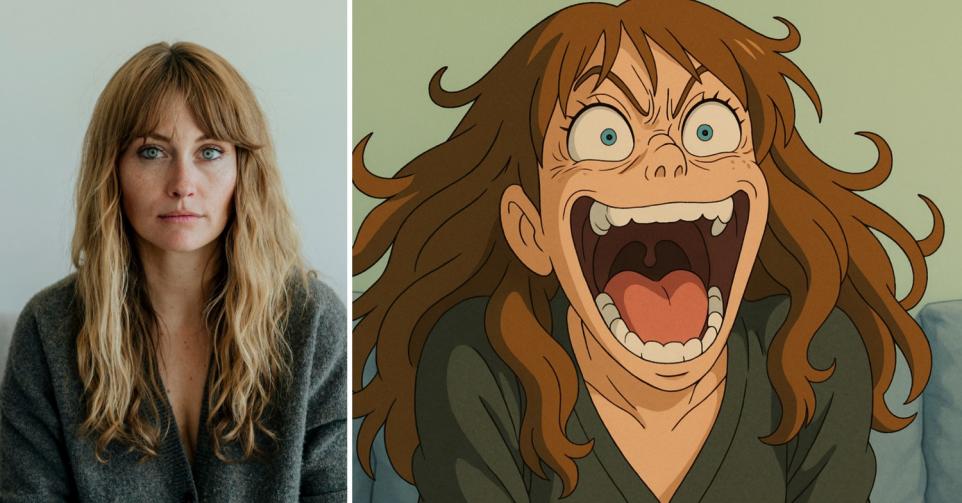

Pour illustrer le phénomène, nous avons soumis la photo d’une femme issue d’une banque d’images à ChatGPT en lui demandant de lui «rendre le sourire», puis de la rendre «encore plus joyeuse», et ce, à quatre reprises. Résultat: la personne représentée sur la cinquième image générée par ChatGPT ne ressemble plus à celle de la photo originale. Elle se pare, en outre, d’une teinte de plus en plus jaunâtre. «C’est un peu comme une photocopieuse qui recopie sans cesse une copie de copie», commente Pierre Schaus, professeur d’informatique à l’UCLouvain.

Consanguine comme les Habsbourg

L’hypothèse de la consanguinité de l’IA n’est pas nouvelle. Le chercheur en théorie sociale des technologies de l’information Jathan Sadowski la théorisait déjà en 2023 sous l’appellation «Habsburg AI». Une référence à la lignée royale des Habsbourg d’Espagne, dont la consanguinité, choisie pour renforcer le pouvoir de la dynastie, avait engendré des difformités chez les plus récents descendants. Certains estiment même que cette consanguinité a conduit à l’extinction de la lignée avec la mort de Charles II, en 1700. De la même façon que ce dernier roi, à force de «reproductions internes», les modèles d’IA pourraient devenir stériles, voire inutiles.

En 2024, une étude britannique publiée dans la revue Nature interrogeait un possible effondrement des modèles d’intelligence artificielle, lorsque ceux-ci sont entraînés sur des données sans cesse recopiées. «L’idée que les modèles d’IA pourraient s’effondrer à cause de l’utilisation croissante de données synthétiques dans leur entraînement est un sujet d’inquiétude légitime, résume Pierre Schaus. En théorie, si les données générées par l’IA remplacent progressivement les données humaines, les modèles pourraient perdre leur ancrage dans la réalité et conduire à une dégradation progressive de la qualité des résultats.»

«Plutôt qu’à un effondrement, on pourrait assister à une boucle vertueuse.»

La question est de savoir si, un jour, les contenus générés par l’IA seront plus nombreux que ceux créés par l’homme. Et donc, si l’intelligence artificielle ne pourra plus se contenter que de données synthétiques. Pas forcément, répond le professeur d’informatique, car il est possible d’anticiper et d’atténuer les conséquences de la consanguinité de l’IA. «Premièrement, les données synthétiques ne remplacent pas brutalement les données humaines. Elles s’y ajoutent, créant un ensemble hybride, argue-t-il. Ne sont généralement publiées sur des sites avec une certaine réputation que des données générées par IA de qualité, validées par des humains. Même si vous vous amusez à générer beaucoup de données avec une IA, celles-ci ne seront pas exploitées dans les ensembles d’apprentissage si elles ne sont pas fiables ou avec une bonne réputation.»

«Deuxièmement, poursuit-il. Les chercheurs et les entreprises ne restent pas passifs. Des techniques de nettoyage des données permettent de filtrer et d’améliorer leur qualité avant leur intégration.» Cependant, souligne l’Institut national (français) de recherche en sciences et technologies du numérique (INRIA), cette curation humaine comporte aussi ses limites, notamment en réduisant la diversité des représentations culturelles et ethniques. «Si la majorité des utilisateurs préfèrent des images dans un certain style (par exemple: visages symétriques, peau lisse et blanche), alors l’IA produira plus souvent ce type d’images au détriment d’autres. Concernant les stéréotypes, lorsqu’on demande à une IA de représenter un métier qui ne comporte pas de distinction entre le féminin et le masculin syntaxiquement parlant, l’IA aura tendance à représenter un homme en CEO et une femme en secrétaire.»

Un pétard mouillé, comme le bug de l’an 2000?

Cette dégénérescence des modèles d’intelligence artificielle n’est pas une fatalité, résume le spécialiste. Ce scénario catastrophe n’est, par ailleurs, pas sans lui rappeler le bug de l’an 2000. A l’approche du nouveau millénaire, les craintes d’un bug qui paralyserait les systèmes informatiques étaient prégnantes. Elles résidaient dans la façon dont avaient été pensées les dates à deux chiffres des horloges internes des premiers ordinateurs: jj/mm/aa. Au passage de 1999 à 2000, beaucoup craignaient que ces ordinateurs pensent erronément être retournés en 1900, rendant certaines machines et programmes inutilisables. Ce vent de panique s’est révélé injustifié: les rares problèmes apparus furent vite résolus.

«On peut imaginer un phénomène inverse où les données synthétiques, bien nettoyées, permettraient d’améliorer itérativement les modèles. Donc, plutôt qu’à un effondrement, on pourrait assister à une boucle vertueuse», conclut Pierre Schaus.